(IoT-) Daten in Echtzeit verarbeiten mit dem Data Integration Hub.

Der erste Schritt zu einem souveränen Data Lake.

Offen, flexibel und bereit für alles, was kommt.

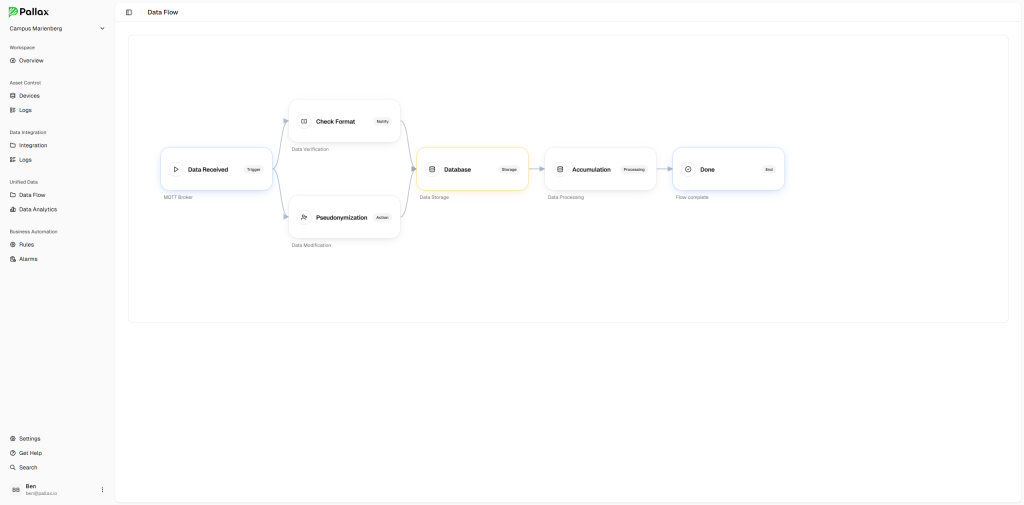

Daten Integration über No-Code Oberfläche

Einfach per Drag & Drop neue Konnektoren anlegen um Daten sicher, schnell und einfach zu integrieren.

Der Pallax Data Integration Hub ist die zentrale Komponente zur intelligenten und sicheren Vernetzung von Datenquellen innerhalb der Pallax-Plattform.

Nahtlose, bidirektionale Integration verschiedenster Datenströme in Echtzeit über offene und bewährte Standards wie API, MQTT, OPC UA oder XML.

Ziel ist es, eine konsolidierte und verlässliche Datenbasis bereitzustellen, die als Grundlage für sämtliche Analyse-, Automatisierungs- und Steuerungsprozesse innerhalb der Plattform dient.

Über eine intuitive No-Code-Oberfläche können Konnektoren per Drag & Drop eingerichtet und konfiguriert werden, ohne Programmierkenntnisse zu benötigen.

Dabei beschränkt sich der Hub nicht nur auf die bloße Datenanbindung. Durch die integrierten Funktionen können eingehende Daten bereits während der Integration verarbeitet, pseudonymisiert oder anonymisiert werden – ein entscheidender Vorteil für datenschutzkonforme Anwendungen.

Der gesamte Datenfluss – vom Ursprungspunkt über die Verarbeitung bis hin zur Speicherung – ist flexibel und granular steuerbar.

So wird der Pallax Data Integration Hub zur Schaltzentrale für moderne, sichere und skalierbare Datenarchitekturen.

Lösungen & Vorteile mit dem Data Integration Hub

Daten sicher integrieren mit der verschlüsselten und authentifizierten Verbindung von der Edge bis zur Pallax-Plattform.

Standardisierte Integration

Durch standardisierte Konnektoren ist die Integration neuer Datenquellen einfach, schnell und sicher eingerichtet – unabhängig vom eingesetzten System.

Unterstützte Hersteller

Die optimierten Konnektoren unterstützter Hersteller erleichtern die Einrichtung und Verarbeitung der unterschiedlichsten Anforderungen.

Intelligentes Pre-Processing

Durch lokales Vorverarbeiten der Rohdaten direkt an der Edge können irrelevante Informationen gefiltert, Standardformate erzeugt und Datenmengen optimiert werden.

Datenqualität & Validierung

Die automatisierten Validierungsmechanismen sorgen für hohe Datenqualität und erkennen fehlerhafte oder unvollständige Datenströme frühzeitig.

Sicherer Datenraum

Der Zugriff auf die verschlüsselten Daten wird durch rollenbasierte Zugriffskontrollen, Protokollierung und Ende-zu-Ende-Verschlüsselung sichergestellt.

Echtzeit Datenströme

Datenströme können – abhängig von Inhalt, Quelle oder Priorität – neben der historischen Speicherung auch in Echtzeit verarbeitet oder weitergeleitet werden.

Sichere Integration über die Pallax Edge Box (PxE)

Daten sicher integrieren mit der verschlüsselten und authentifizierten Verbindung von der Edge bis zur Pallax-Plattform.

Die Pallax Edge Box (PXE) ist für eine Vielzahl von Einsatzzwecken geeignet. Die Hardware erfüllt industrielle Anforderungen, ist für den Einsatz in Bus und Bahn zertifiziert und mit einem gehärteten Linux-Betriebssystem ausgestattet.

Unsere Pallax Edge Software wird darauf sicher in einem geschützten Container ausgeführt und ermöglicht den direkten Anschluss von Datenquellen über IP, serielle Schnittstellen oder andere industrielle Protokolle.

Bereits an der Edge übernimmt die Software das Datenhandling, bereitet die Rohdaten vor und wandelt sie bei Bedarf in Standardformate um.

Über eine verschlüsselte und authentifizierte Verbindung werden diese Daten anschließend an den Pallax Data Integration Hub übertragen – als wäre der Hub direkt vor Ort installiert.

Optimierte Workflows zur Integration der Daten

Von der Rohdatenerfassung bis zur zielgerichteten Nutzung – nahtlose Prozesse für hochwertige Datenintegration.

Die Integration von Daten aus unterschiedlichsten Quellen erfordert klare Strukturen und intelligente Abläufe. Mit dem Data Integration Hub werden Daten nicht nur sicher und standardisiert übernommen, sondern auch durch automatisierte Workflows effizient validiert, transformiert und weiterverarbeitet.

Diese Workflows ermöglichen eine dynamische Steuerung der Datenströme – je nach Quelle, Inhalt oder Priorität – und sorgen so für eine reibungslose und skalierbare Datenverarbeitung in Echtzeit. Das reduziert manuelle Aufwände und schafft die Grundlage für durchgängige, hochwertige Datenprozesse.